KI Geschichte

Geschichte

Die Entwicklung der Künstlichen Intelligenz (KI) ist eine faszinierende Reise durch Wissenschaft, Technik und menschliche Vorstellungskraft. Von den ersten Ideen über Rückschläge bis hin zu den bahnbrechenden Fortschritten der letzten Jahre – die Geschichte der KI spiegelt den stetigen Wandel unserer Technologien und Gesellschaft wider.

← Zurück zur Startseite

Die Anfänge:

Die Geschichte der Künstlichen Intelligenz beginnt mit dem britischen Mathematiker und Logiker Alan Turing (1912–1954). Während des Zweiten Weltkriegs spielte Turing eine entscheidende Rolle bei der Entschlüsselung der deutschen Enigma-Codes, was maßgeblich zum Sieg der Alliierten beitrug. Nach dem Krieg stellte er 1950 die berühmte Frage: „Können Maschinen denken?“ In seinem Aufsatz „Computing Machinery and Intelligence“ schlug er den Turing-Test vor – ein Verfahren, bei dem eine Maschine als intelligent gilt, wenn sie in einem Gespräch nicht von einem Menschen zu unterscheiden ist. Turings visionäre Ideen legten den Grundstein für die spätere KI-Forschung und inspirierten Generationen von Wissenschaftlern.

Die Geschichte der Künstlichen Intelligenz beginnt mit dem britischen Mathematiker und Logiker Alan Turing (1912–1954). Während des Zweiten Weltkriegs spielte Turing eine entscheidende Rolle bei der Entschlüsselung der deutschen Enigma-Codes, was maßgeblich zum Sieg der Alliierten beitrug. Nach dem Krieg stellte er 1950 die berühmte Frage: „Können Maschinen denken?“ In seinem Aufsatz „Computing Machinery and Intelligence“ schlug er den Turing-Test vor – ein Verfahren, bei dem eine Maschine als intelligent gilt, wenn sie in einem Gespräch nicht von einem Menschen zu unterscheiden ist. Turings visionäre Ideen legten den Grundstein für die spätere KI-Forschung und inspirierten Generationen von Wissenschaftlern.

Die Geburtsstunde der KI:

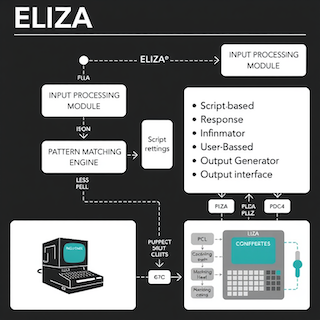

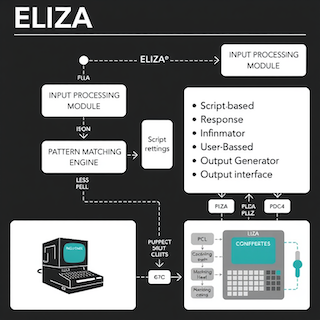

Als eigentliche Geburtsstunde der KI gilt die Dartmouth-Konferenz im Sommer 1956 im US-Bundesstaat New Hampshire. Dort versammelten sich führende Wissenschaftler wie John McCarthy (der den Begriff „Artificial Intelligence“ prägte), Marvin Minsky, Claude Shannon und Allen Newell, um die Grundlagen einer neuen Forschungsrichtung zu legen. Ziel war es, Maschinen zu bauen, die „lernen, wie Menschen Probleme lösen“. In den folgenden Jahren entstanden erste Programme wie das Logic Theorist (1955) von Newell und Simon, das mathematische Beweise führen konnte, und ELIZA (1966), das als einfacher Chatbot Psychotherapie-Gespräche simulierte. Diese frühen Systeme zeigten das Potenzial, aber auch die Grenzen der damaligen KI.

Als eigentliche Geburtsstunde der KI gilt die Dartmouth-Konferenz im Sommer 1956 im US-Bundesstaat New Hampshire. Dort versammelten sich führende Wissenschaftler wie John McCarthy (der den Begriff „Artificial Intelligence“ prägte), Marvin Minsky, Claude Shannon und Allen Newell, um die Grundlagen einer neuen Forschungsrichtung zu legen. Ziel war es, Maschinen zu bauen, die „lernen, wie Menschen Probleme lösen“. In den folgenden Jahren entstanden erste Programme wie das Logic Theorist (1955) von Newell und Simon, das mathematische Beweise führen konnte, und ELIZA (1966), das als einfacher Chatbot Psychotherapie-Gespräche simulierte. Diese frühen Systeme zeigten das Potenzial, aber auch die Grenzen der damaligen KI.

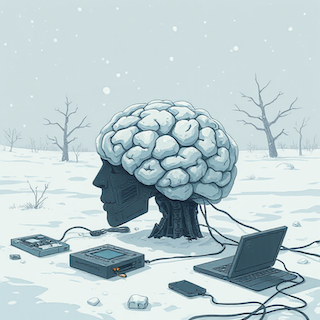

Rückschläge und KI-Winter:

Die Anfangseuphorie wich bald Ernüchterung: Die frühen KI-Systeme stießen schnell an ihre Grenzen. Die verfügbaren Computer waren langsam, der Speicher begrenzt, und die Algorithmen konnten nur einfache Probleme lösen. Viele Annahmen über schnelle Fortschritte erwiesen sich als zu optimistisch. In den 1970er- und später erneut in den 1980er-Jahren kam es zu sogenannten „KI-Wintern“: Die Erwartungen an die Technologie konnten nicht erfüllt werden, Fördermittel wurden gestrichen und das öffentliche Interesse ließ nach. Gründe waren u.a. mangelnde Rechenleistung, fehlende große Datensätze, begrenzte Lernfähigkeit der Programme und eine Kluft zwischen Theorie und praktischer Anwendung.

Die Anfangseuphorie wich bald Ernüchterung: Die frühen KI-Systeme stießen schnell an ihre Grenzen. Die verfügbaren Computer waren langsam, der Speicher begrenzt, und die Algorithmen konnten nur einfache Probleme lösen. Viele Annahmen über schnelle Fortschritte erwiesen sich als zu optimistisch. In den 1970er- und später erneut in den 1980er-Jahren kam es zu sogenannten „KI-Wintern“: Die Erwartungen an die Technologie konnten nicht erfüllt werden, Fördermittel wurden gestrichen und das öffentliche Interesse ließ nach. Gründe waren u.a. mangelnde Rechenleistung, fehlende große Datensätze, begrenzte Lernfähigkeit der Programme und eine Kluft zwischen Theorie und praktischer Anwendung.

Neuer Aufschwung durch Expertensysteme:

In den 1980er-Jahren gelang der KI ein Comeback durch sogenannte Expertensysteme. Diese Programme konnten in eng abgegrenzten Fachgebieten – wie Medizin, Technik oder Finanzwesen – Expertenwissen abbilden und logische Schlussfolgerungen ziehen. Prominente Beispiele sind MYCIN zur Diagnose bakterieller Infektionen und XCON zur Konfiguration von Computersystemen bei DEC. Obwohl sie beeindruckende Ergebnisse in Nischen erzielten, waren Expertensysteme schwer zu warten, konnten ihr Wissen nicht selbstständig erweitern und scheiterten oft an komplexen, unscharfen Problemen. Dennoch schufen sie die Grundlage für kommerzielle KI-Anwendungen und weckten erneutes Interesse an der Forschung.

In den 1980er-Jahren gelang der KI ein Comeback durch sogenannte Expertensysteme. Diese Programme konnten in eng abgegrenzten Fachgebieten – wie Medizin, Technik oder Finanzwesen – Expertenwissen abbilden und logische Schlussfolgerungen ziehen. Prominente Beispiele sind MYCIN zur Diagnose bakterieller Infektionen und XCON zur Konfiguration von Computersystemen bei DEC. Obwohl sie beeindruckende Ergebnisse in Nischen erzielten, waren Expertensysteme schwer zu warten, konnten ihr Wissen nicht selbstständig erweitern und scheiterten oft an komplexen, unscharfen Problemen. Dennoch schufen sie die Grundlage für kommerzielle KI-Anwendungen und weckten erneutes Interesse an der Forschung.

Durchbruch in den 1990er-Jahren:

Ein international beachteter Meilenstein war der Sieg von IBMs Schachcomputer Deep Blue über den amtierenden Weltmeister Garry Kasparov im Jahr 1997. Deep Blue war das Ergebnis jahrelanger Forschung, spezialisierter Hardware und ausgefeilter Algorithmen. Das Match gegen Kasparov wurde weltweit übertragen und zeigte, dass Computer in bestimmten Aufgabenbereichen menschliche Fähigkeiten übertreffen können. Deep Blue analysierte Millionen von Zügen pro Sekunde, nutzte eine riesige Eröffnungsbibliothek und bewies das Potenzial von KI im Bereich der Entscheidungsfindung und Strategie.

Ein international beachteter Meilenstein war der Sieg von IBMs Schachcomputer Deep Blue über den amtierenden Weltmeister Garry Kasparov im Jahr 1997. Deep Blue war das Ergebnis jahrelanger Forschung, spezialisierter Hardware und ausgefeilter Algorithmen. Das Match gegen Kasparov wurde weltweit übertragen und zeigte, dass Computer in bestimmten Aufgabenbereichen menschliche Fähigkeiten übertreffen können. Deep Blue analysierte Millionen von Zügen pro Sekunde, nutzte eine riesige Eröffnungsbibliothek und bewies das Potenzial von KI im Bereich der Entscheidungsfindung und Strategie.

Moderne KI – Big Data und Deep Learning:

Mit dem Einzug des 21. Jahrhunderts veränderten sich die Rahmenbedingungen grundlegend. Die Verfügbarkeit riesiger Datenmengen („Big Data“) und die Entwicklung leistungsstarker Grafikprozessoren (GPUs) ermöglichten es, komplexe neuronale Netze effizient zu trainieren. Ein Schlüsselmoment war die ImageNet-Wettbewerb 2012, bei dem ein Deep-Learning-Modell von AlexNet die Bildklassifikation revolutionierte. Seither finden KI-Technologien breite Anwendung: in Sprachassistenten, Übersetzungsdiensten, Gesichtserkennung, autonomen Fahrzeugen und vielen Alltagsprodukten. KI ist heute fester Bestandteil von Smartphones, Suchmaschinen und medizinischer Diagnostik.

Mit dem Einzug des 21. Jahrhunderts veränderten sich die Rahmenbedingungen grundlegend. Die Verfügbarkeit riesiger Datenmengen („Big Data“) und die Entwicklung leistungsstarker Grafikprozessoren (GPUs) ermöglichten es, komplexe neuronale Netze effizient zu trainieren. Ein Schlüsselmoment war die ImageNet-Wettbewerb 2012, bei dem ein Deep-Learning-Modell von AlexNet die Bildklassifikation revolutionierte. Seither finden KI-Technologien breite Anwendung: in Sprachassistenten, Übersetzungsdiensten, Gesichtserkennung, autonomen Fahrzeugen und vielen Alltagsprodukten. KI ist heute fester Bestandteil von Smartphones, Suchmaschinen und medizinischer Diagnostik.

Fazit und Ausblick:

Die Geschichte der KI ist geprägt von großen Hoffnungen, Rückschlägen und immer neuen Durchbrüchen. Sie verläuft in Wellen – auf Phasen des Optimismus folgen Zeiten der Skepsis, bevor neue technologische Entwicklungen den nächsten Sprung ermöglichen. Heute steht KI im Zentrum gesellschaftlicher Debatten: Datenschutz, Ethik, Kontrolle und Verantwortung werden immer wichtiger. Die Zukunft der KI bleibt offen – doch die Erfahrungen der Vergangenheit zeigen, dass Forschung und Innovation weiterhin unser Verständnis von Intelligenz und Technologie herausfordern und erweitern werden.

Die Geschichte der KI ist geprägt von großen Hoffnungen, Rückschlägen und immer neuen Durchbrüchen. Sie verläuft in Wellen – auf Phasen des Optimismus folgen Zeiten der Skepsis, bevor neue technologische Entwicklungen den nächsten Sprung ermöglichen. Heute steht KI im Zentrum gesellschaftlicher Debatten: Datenschutz, Ethik, Kontrolle und Verantwortung werden immer wichtiger. Die Zukunft der KI bleibt offen – doch die Erfahrungen der Vergangenheit zeigen, dass Forschung und Innovation weiterhin unser Verständnis von Intelligenz und Technologie herausfordern und erweitern werden.